Le lien entre la Metaverse et l'informatique : l'estimation du besoin d'une plus grande puissance de calcul, l'informatique décentralisée...

Voici la quatrième partie de « Qu’est-ce que le Metaverse – le guide ultime pour tout comprendre ». Ici, l’informatique est définie comme « l’activation et la fourniture de la puissance de calcul pour soutenir le Metaverse, en prenant en charge des fonctions aussi diverses et exigeantes que le calcul physique, le rendu, la réconciliation et la synchronisation des données, l’intelligence artificielle, la projection, la capture de mouvement et la traduction ».

Pas le temps de tout lire ? Clique pour aller directement à la partie qui t’intéresse le plus :

→ Estimation du besoin d’une plus grande puissance de calcul

Estimation du besoin d'une plus grande puissance de calcul

Dans les catégories matériel et infrastructure, je n’ai examiné qu’une partie des données incrémentielles qui seront générées, envoyées et reçues dans le cadre du Metaverse – comme l’haptique, la numérisation du visage et la numérisation de l’environnement en direct. Le champ d’application complet sera beaucoup plus vaste.

Par exemple, le fondateur et PDG de Nvidia, Jensen Huang, considère que la prochaine étape des simulations immersives ne se limite pas à des explosions ou des courses de rue plus réalistes. Il s’agit plutôt de l’application des « lois de la physique des particules, de la gravité, de l’électromagnétisme, des ondes électromagnétiques, [y compris] la lumière et les ondes radio… de la pression et du son ». Et tout comme le monde virtuel est augmenté, le monde « réel » le sera aussi. Chaque année, davantage de capteurs, de caméras et de puces IoT seront intégrés au monde physique qui nous entoure, dont beaucoup seront connectés en temps réel à un simulacre virtuel qui pourra interagir en retour. Pendant ce temps, nos appareils personnels serviront de passeport pour nombre de ces expériences, et de générateur à temps partiel de celles-ci. En bref, une grande partie du monde qui nous entoure sera continuellement interconnectée et en ligne. Nous y compris.

Dans l’ensemble, le Metaverse aura les plus grands besoins permanents en matière de calcul de l’histoire de l’humanité. Et l’informatique est, et restera probablement, incroyablement rare. Pour citer Chris Dixon, associé général d’Andreessen Horowitz, « toutes les bonnes ressources informatiques dans le monde, dans l’histoire, ont vu la demande dépasser l’offre… c’est vrai pour la puissance des CPU. C’est vrai pour la puissance des GPU ». Par conséquent, la disponibilité et le développement de la puissance de calcul vont contraindre et définir le Metaverse (même si les utilisateurs finaux ne s’en rendent pas compte). Peu importe la quantité de données que vous pouvez recevoir, la vitesse à laquelle vous les recevez ou les raisons pour lesquelles vous les recevez, si elles ne peuvent pas être utilisées.

Considérez les expériences de type Metaverse les plus populaires aujourd’hui, comme Fortnite ou Roblox. Si ces plateformes connaissent le succès grâce à d’incroyables réalisations créatives, il est important de reconnaître que leurs idées sous-jacentes sont loin d’être nouvelles – elles sont simplement nouvellement possibles. Les développeurs imaginent depuis longtemps des expériences avec des dizaines de joueurs (voire des centaines ou des milliers) dans une simulation unique et partagée, ainsi que des environnements virtuels qui ne sont liés que par l’imagination.

Ce n’est qu’au milieu des années 2010 que des millions d’appareils grand public ont pu traiter une partie avec 100 joueurs réels en un seul match, et que suffisamment de matériel abordable, côté serveur, était disponible et capable de synchroniser ces informations en quasi temps réel. Une fois cette barrière technique franchie, l’industrie des jeux a été rapidement dépassée par des jeux axés sur un CGU riche et un grand nombre d’utilisateurs simultanés (Free Fire, PUBG, Fortnite, Call of Duty : Warzone, Roblox, Minecraft). Et ces jeux se sont ensuite rapidement étendus aux types d’expériences médiatiques qui étaient auparavant « IRL seulement » (par exemple, le concert de Travis Scott dans Fortnite, ou les X de Lil Nas dans Roblox).

Pourtant, même quatre ans après l’apparition du genre de la bataille royale, un certain nombre d’astuces sont encore nécessaires pour assurer son bon fonctionnement. Par exemple, la plupart des joueurs ne sont jamais vraiment ensemble. Au contraire, ils sont éparpillés sur une grande carte. Cela signifie que, bien que le serveur doive suivre ce que fait chaque joueur, l’appareil de chaque joueur n’a pas besoin de les restituer ou de suivre/traiter leurs actions. Et lorsque Fortnite rassemble les joueurs dans un espace plus confiné pour un événement social, comme un concert, il réduit le nombre de participants à 50, et limite ce qu’ils peuvent faire par rapport aux modes de jeu standard. Et pour les utilisateurs disposant de processeurs moins puissants, d’autres compromis sont faits.

Les appareils de quelques années choisiront de ne pas charger les tenues personnalisées des autres joueurs (car elles n’ont aucune conséquence sur le gameplay) et se contenteront de les représenter comme des personnages de stock. Notamment, Free Fire, qui est uniquement mobile et se joue principalement sur des Androïdes de bas à moyen de gamme dans les marchés émergents, est plafonné à 50 pour le mode principal de bataille royale.

"Cela me fait me demander où iront les futures évolutions de ces types de jeux que nous ne pouvons pas construire aujourd'hui. Notre pic est de 10,7 millions de joueurs dans Fortnite - mais c'est 100 000 sessions de cent joueurs. Pourrons-nous un jour les réunir tous dans ce monde partagé ? Et à quoi ressemblerait cette expérience ? Il y a des genres entièrement nouveaux qui ne peuvent même pas encore être inventés en raison de la tendance toujours ascendante de la technologie."

Tim Sweeney - Fondateur et PDG d'Epic Games (2019)

Ce problème sera lentement résolu, bien sûr. Call of Duty : Warzone proposait des matchs à 150 joueurs en 2019 (mais uniquement sur les consoles et les PC les plus puissants ; Call of Duty Mobile est limité à 100). Roblox a également autorisé 200 joueurs dans ses mondes de fidélité relativement inférieure, avec jusqu’à 700 possibles en test bêta (et plus de 1 000 promis). Improbable a effectué des tests publics avec 4 000 joueurs. Mais « plus d’utilisateurs simultanés » n’est pas la seule demande pour nos appareils informatiques. Nous voulons que nos personnages dans Fortnite aient plus d’objets personnalisables qu’une simple tenue et un sac à dos. Pourquoi pas des chaussures et des chapeaux séparés ? La possibilité de participer à un concert virtuel, plutôt que d’y assister à partir d’une zone fermée et peu interactive ?

Pour revenir à un exemple précédent, moins de 1 % des Mac et PC de bureau ou portables peuvent même jouer à Microsoft Flight Simulator dans ses paramètres de fidélité les plus bas. Même les consoles Xbox de nouvelle génération de Microsoft, les séries S et X, qui sont sorties deux mois après le titre, ne le prennent pas encore en charge (mais elles le feront plus tard cette année).

Cela ne signifie pas que toutes les expériences axées sur le Metaverse nécessiteront un traitement riche et instantané (pensez à une salle de conférence skeuomorphique), et encore moins tout le temps (les expériences immersives sont meilleures en haute fidélité, mais il est préférable de pouvoir y accéder à partir de plusieurs appareils que de ne pouvoir y accéder qu’à partir de votre meilleur appareil).

Mais l’histoire de l’humanité montre qu’une puissance de calcul supplémentaire entraîne toujours des avancées – c’est exactement la raison pour laquelle la demande de calcul a toujours dépassé son offre. À cet effet, le désir de Jensen Huang d’imiter le dessein divin peut sembler excessif et peu pratique, mais cela nécessite de prévoir et d’écarter les innovations qui pourraient en découler. Qui aurait pensé que permettre des battle royales à 100 joueurs changerait le monde ?

Où localiser et développer l'informatique ?

Il existe plusieurs écoles de pensée différentes lorsqu’il s’agit de répondre à nos besoins toujours croissants en matière de calcul et à sa relative rareté. L’une d’elles consiste à concentrer autant de traitements de simulation que possible dans le cloud, plutôt que sur des dispositifs informatiques locaux. Google Stadia et Amazon Luna, par exemple, traitent tous les jeux vidéo dans le cloud, puis transmettent l’ensemble du rendu à l’appareil de l’utilisateur sous forme de flux vidéo. La seule chose qu’un appareil client doit faire est de lire cette vidéo et d’envoyer des entrées (par exemple, se déplacer vers la gauche, appuyer sur X).

Les partisans de cette approche aiment à souligner la logique de l’alimentation de nos foyers par des réseaux électriques et des centrales industrielles, et non par des générateurs privés, propres à chaque foyer.

Le modèle basé sur le cloud permet aux consommateurs de remplacer leurs ordinateurs de qualité grand public, rarement mis à jour et marqués par les détaillants, par des machines de qualité professionnelle « ridicules sur le plan informatique » (pour citer Jeff Bezos) qui sont plus rentables par unité de puissance de traitement et plus faciles à remplacer. En d’autres termes, que vous possédiez un iPhone à 1 500 dollars ou un vieux réfrigérateur Wi-Fi équipé d’un écran vidéo, vous pourriez en théorie jouer à Cyberpunk 2077 dans toute sa splendeur.

Une autre thèse suggère qu’il est préférable de miser sur les progrès de l’informatique locale, plutôt que sur des superordinateurs distants qui doivent ensuite faire face à des réseaux peu fiables (voir section 2). Le rendu et le streaming vidéo dans le cloud sont une idée séduisante, mais ils augmentent aussi considérablement la quantité de données à faible latence qui doivent être fournies. Comme nous l’avons mentionné précédemment, le contenu des jeux vidéo vise un minimum de 60 images par seconde (plus du double de la norme pour la vidéo) et jusqu’à 90-120 images, idéalement en définition 2K à 4K. Fournir cela de manière fiable, à tous ceux qui veulent participer au Metaverse, au même moment et avec une faible latence… est vraiment difficile. C’est là que l’analogie avec le générateur d’énergie commence à s’effondrer ; nous ne nous battons pas pour obtenir l’énergie dont nous avons besoin quotidiennement, ni aussi rapidement que nécessaire.

Et même avec une latence ultra-faible, il est peu judicieux de diffuser (plutôt que de traiter localement) des données de réalité augmentée, étant donné la vitesse à laquelle une caméra se déplace et les nouvelles données d’entrée sont reçues (c’est-à-dire littéralement à la vitesse de la lumière et à une distance de quelques mètres seulement). Compte tenu des exigences de calcul intensif de la RA, il est donc probable que nos appareils personnels/mobiles de base seront capables de faire un travail « suffisant » pour un rendu en temps réel.

Jusqu’à présent, le calcul à distance ne s’est pas révélé beaucoup plus efficace pour le rendu non plus. En effet, les GPU basés sur le cloud ne génèrent pas de « puissance » de rendu générique. En fait, il s’agit d’instances verrouillées. Un seul GPU, distant ou local, ne prend en charge le rendu que pour un seul utilisateur. Personne n’a encore trouvé le moyen de répartir sa puissance de rendu entre plusieurs utilisateurs de manière efficace, rentable et conforme aux attentes modernes en matière de résolution et de framerate, de la même manière qu’un plan d’électricité répartit l’électricité entre plusieurs foyers ou qu’un serveur CPU peut prendre en charge les données d’entrée, de localisation et de synchronisation pour une centaine de joueurs dans une bataille royale.

Par conséquent, les serveurs de rendu en cloud sont généralement confrontés à des problèmes d’utilisation en raison de la nécessité de prévoir les pics de demande. Un service de jeu en cloud peut nécessiter 75 000 serveurs dédiés pour la région de Cleveland à 20 heures le dimanche soir, mais seulement 4 000 à 4 heures le lundi matin. En tant que consommateur, vous pouvez acheter un GPU à 400 $ et le laisser hors ligne autant que vous le souhaitez, mais l’économie des centres de données est orientée vers l’optimisation de la demande.

C’est pourquoi AWS accorde aux clients un tarif réduit s’ils louent des serveurs à Amazon à l’avance (« instances réservées »). Les clients ont un accès garanti pour l’année suivante, car ils ont payé le serveur, et Amazon empoche la différence entre son coût et le prix payé par le client (l’instance réservée Linux GPU la moins chère d’AWS, équivalente à une PS4, coûte plus de 2 000 dollars pour un an). Si un client souhaite accéder à des serveurs lorsqu’il en a besoin (« instances ponctuelles »), il peut constater qu’ils ne sont pas disponibles, ou que seuls des GPU bas de gamme sont disponibles, ou encore que seuls des GPU d’une autre région le sont, ce qui implique une plus grande latence.

Si ce modèle décolle, les prix s’amélioreront ( » la marge d’AWS pour les instances réservées aux consommateurs est mon opportunité « ), mais la location de GPU haut de gamme avec une faible utilisation et une marge d’entreprise sera toujours coûteuse. Les centres de données génèrent également une chaleur considérable, dont le refroidissement nécessite une énergie coûteuse, et le passage du cloud-streaming de données au contenu haute résolution et à taux d’images élevé implique également des coûts de bande passante nettement plus élevés. Ces deux dépenses s’additionnent par rapport à l’informatique locale.

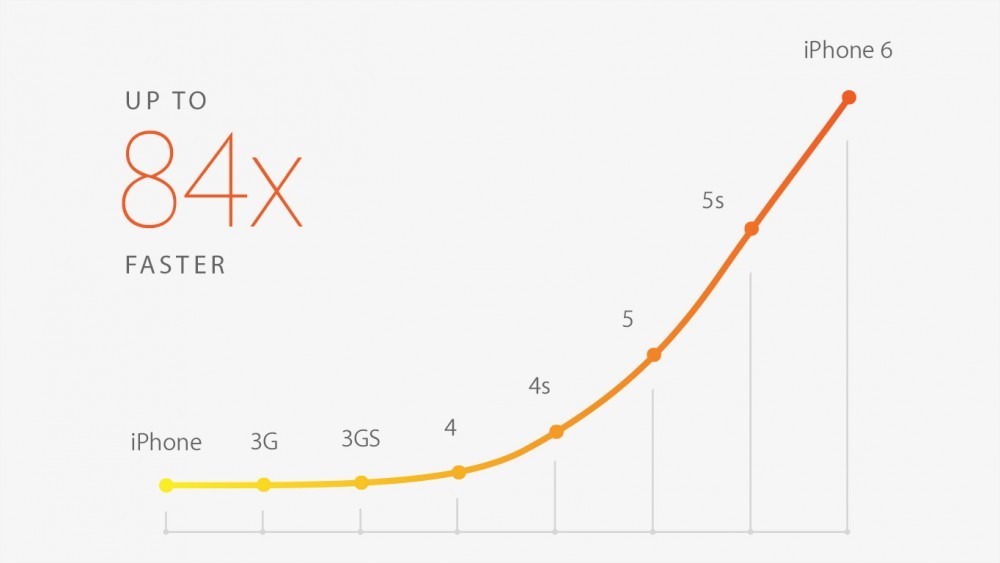

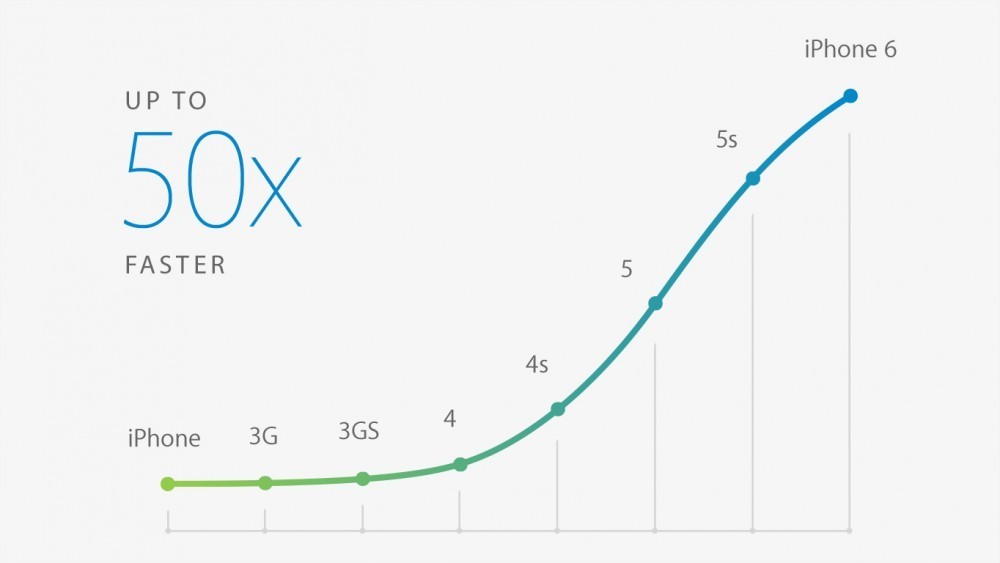

Plus important encore, les processeurs des consommateurs s’améliorent beaucoup plus rapidement que les réseaux, car ils sont remplacés beaucoup plus fréquemment et ne luttent pas littéralement contre la vitesse de la lumière. Cette croissance n’atténue pas tous les problèmes de réseau, mais elle suggère qu’il est préférable de demander aux appareils côté client d’effectuer davantage de calculs plutôt que de leur envoyer des flux vidéo lourds. Cela peut changer avec le temps, mais la loi de Sweeney semble devoir se maintenir dans un avenir prévisible.

Courbe montrant l’évolution de la vitesse de calculs entre les différentes générations d’iPhone.

Processeur graphique (GPU) en haut ⬆ et Processeur (CPU) en bas ⬇

L’informatique en périphérie est souvent présentée comme une stratégie d’infrastructure clé pour le Metaverse. Plus précisément, ce modèle implique le déploiement de superordinateurs aux nœuds clés du réseau, entre les consommateurs et les serveurs centraux plus éloignés. L’informatique de périphérie est compatible avec les deux écoles de pensée susmentionnées et s’y ajoute, car elle aide les utilisateurs finaux à compléter leur informatique locale tout en minimisant les risques de latence et de congestion du réseau.

La valeur appliquée de cette approche reste incertaine. xCloud de Microsoft, par exemple, fonctionne à partir des centres de données Azure standard plutôt qu’en périphérie. Cela est probablement dû au problème d’utilisation des services en nuage mentionné plus haut : plus vous exploitez de centres de périphérie, plus les problèmes d’utilisation sont graves. La plupart des services grand public qui utilisent l’edge computing, comme Netflix, s’en servent en réalité comme d’un disque dur périphérique qui stocke les fichiers plus près de l’utilisateur.

Matthew Prince, fondateur et PDG de Cloudflare, a fait valoir que l’opportunité pour l’informatique périphérique réside dans la conformité. À mesure que l’internet se fragmente en raison des réglementations gouvernementales exigeant le traitement local des données des utilisateurs, les entreprises n’auront d’autre choix que de rapprocher le stockage et le traitement de ces données de l’utilisateur. Il en sera probablement de même dans le Metaverse ; les exigences gouvernementales (qu’il s’agisse du GDPR ou du CCPA) ne feront que s’alourdir avec le temps, comme c’est déjà le cas depuis longtemps en Chine et en Russie.

Et tandis que Google croit fermement à l’informatique périphérique, Apple pense que le véritable mode de calcul « périphérique » de l’avenir sera constitué par les téléphones mobiles de plus en plus puissants que nous avons dans la poche, car ils supporteront la majeure partie de la charge des autres appareils qui nous entourent, tels que les montres et les lunettes intelligentes.

Mais même si nous améliorons la puissance de calcul des appareils grand public, si nous rapprochons la puissance de calcul des entreprises des consommateurs et si nous mettons en place une infrastructure plus centralisée, nous risquons de ne pas être à la hauteur.

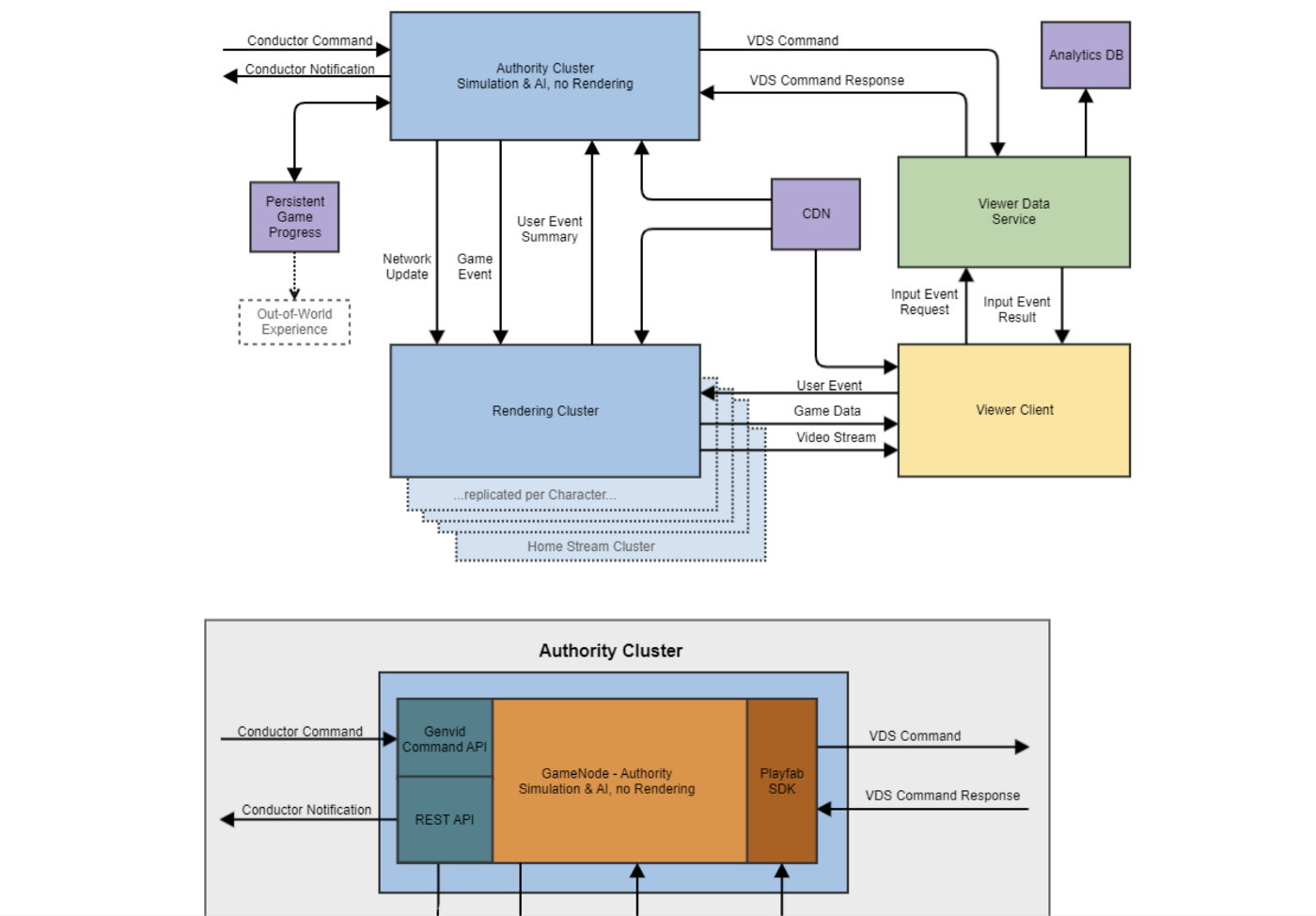

Voici un exemple qui m’a choqué plus tôt cette année. De décembre 2020 à mars 2021, Genvid Technologies, a exploité son premier grand » MILE » (ou Massively Interactive Live Event) sur Facebook Watch. Ce MILE, Rival Peak, était une sorte d’American Idol x LOST x Big Brother virtualisé, une simulation de 13 semaines, 24 heures sur 24 et 7 jours sur 7, de 13 candidats IA piégés dans un Nord-Ouest Pacifique fictif. Bien qu’aucun personnage ne soit contrôlé individuellement, et qu’aucun spectateur ne soit un personnage individuel, des dizaines de milliers de spectateurs simultanés étaient en mesure d’influencer la simulation en temps réel – en résolvant des énigmes pour aider les concurrents, en choisissant ce qu’ils pouvaient faire, et même en influençant les survivants et les exclus. Rival Peak n’aurait jamais pu fonctionner sur un appareil grand public (son CCU élevé fonctionnait malgré la latence car il était conçu pour des interactions à faible latence).

En fait, il a à peine fonctionné sur AWS. Avec huit environnements (production, sauvegarde, staging, QA et développement), dont chacun était pris en charge par plus d’une douzaine de GPU et des centaines d’autres CPU, Rival Peak n’a jamais été à court de serveurs GPU sur AWS et, pendant les tests, a régulièrement épuisé les serveurs spot disponibles.

Schéma des interactions entre les différentes parties d’un serveur de jeu pour s’assurer de la cohérence entre les données affichées en jeu, et celles présentes sur le serveur.

Parce qu’il n’y avait pas de joueurs spécifiques (et encore moins de « joueur unique »), Rival Peak ne correspond pas à la définition instinctive du Metaverse. Cependant, l’exploitation d’un monde virtuel persistant et sans fin qui permet des interactions illimitées, chacune ayant des conséquences durables, est aussi proche que possible de l’état final du Metaverse. Et même dans sa forme naissante, et sans nécessiter de traitement significatif du côté du consommateur, il manquait de puissance de calcul.

Imaginez ce qui est nécessaire pour la vision de Nvidia d’un monde miroir interconnecté. Ou le type de simulation nécessaire pour cartographier l’ensemble de la géométrie d’une ville, puis ajuster tout, des feux de circulation aux ondes radio 5G, afin d’optimiser le flux de personnes et d’informations en temps réel. Rien que pour le MILE de l’année prochaine (pas encore annoncé), Genvid aura besoin de 200 % de GPU et de CPU supplémentaires.

Informatique décentralisée

Le besoin insatiable de traitement – idéalement situé aussi près que possible de l’utilisateur, mais même près de fermes de serveurs industrielles – inspire invariablement des notions d’informatique décentralisée. Avec autant d’appareils puissants et souvent inactifs dans les foyers et les mains des consommateurs, il semble inévitable que nous développions des systèmes pour les utiliser efficacement. Culturellement, du moins, cette idée est déjà bien comprise.

Quiconque installe des panneaux solaires chez lui peut vendre l’excédent d’électricité à son réseau local (et, indirectement, à son voisin). Elon Musk vante un avenir où votre Tesla vous rapporte un loyer en tant que voiture autonome lorsqu’elle n’est pas utilisée, au lieu d’être simplement garée dans votre garage pendant 99 % de sa vie.

Il y avait un élément amusant sur ma liste de choses à faire en 1998, lorsque nous avons livré le premier jeu Unreal. Il s'agissait de permettre aux serveurs de jeu de communiquer entre eux afin de pouvoir accueillir un nombre illimité de joueurs dans une seule session de jeu. La question de savoir si vous pouvez construire un jeu auquel plusieurs millions de joueurs peuvent jouer, tous dans un monde partagé, ensemble, c'est un défi vraiment intéressant pour l'industrie du jeu maintenant.

Tim Sweeney - Fondateur et PDG d'Epic Games (2019)

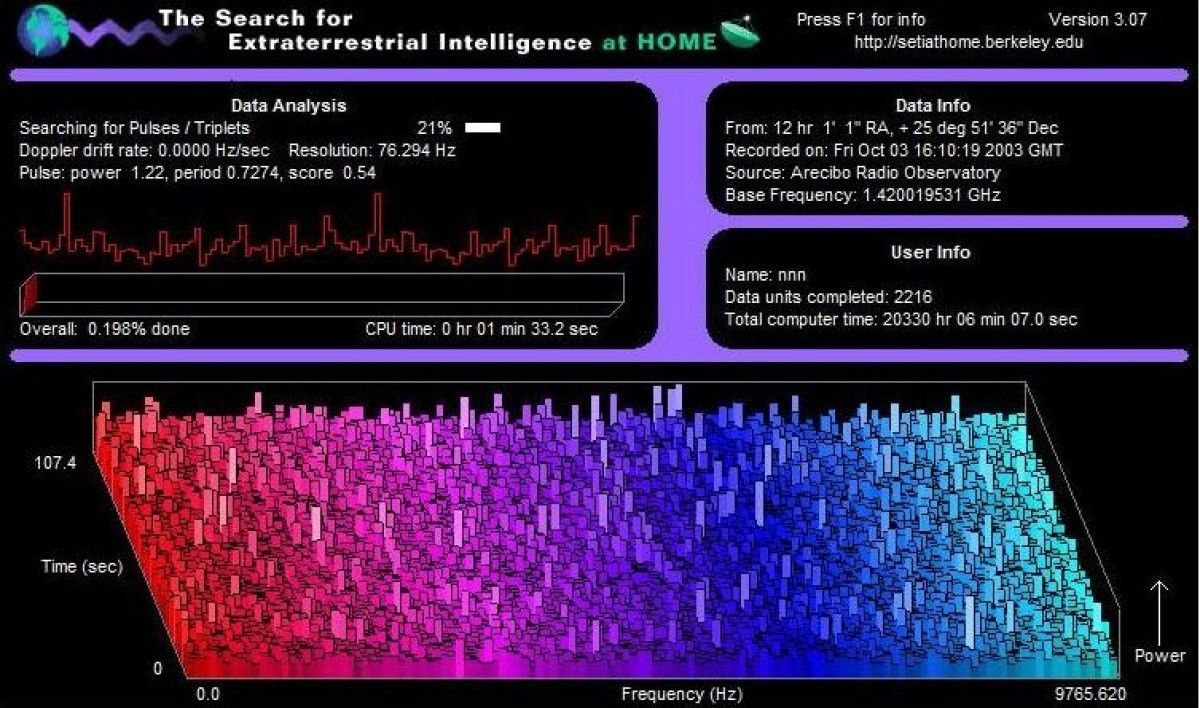

En fait, dès les années 1990, des programmes ont émergé pour l’informatique distribuée en utilisant du matériel grand public de tous les jours. Parmi les exemples, citons le SETI@HOME de Berkeley, dans lequel les consommateurs utilisaient bénévolement leurs ordinateurs personnels pour alimenter la recherche de vie extraterrestre. Mais les concepts plus récents de blockchain, notamment les contrats intelligents et les jetons, fournissent un modèle économique pour ce partage. Dans cette conception, les propriétaires de CPU et de GPU sous-utilisés seraient « payés » en crypto-monnaies pour l’utilisation de leurs capacités de traitement, peut-être par des utilisateurs situés « près » d’eux dans la topologie du réseau. Il pourrait même y avoir une vente aux enchères en direct pour l’accès à ces ressources, les personnes ayant des « emplois » faisant des offres d’accès, ou celles ayant des capacités faisant des offres d’emplois.

Un exemple de ce mécanisme est le réseau de rendu d’OTOY. En tant que premier raytracer non biaisé utilisant entièrement le GPU, Octane Render a ouvert la voie à des délais d’exécution permettant de modifier des scènes en temps réel. Mais pour que ses utilisateurs – qui comprenaient des studios d’effets spéciaux, des artistes, des animateurs, des concepteurs, des architectes et des ingénieurs – puissent profiter de ces capacités révolutionnaires, ils devaient avoir accès à de puissantes capacités de traitement en temps réel.

OTOY a eu l’idée d’exploiter un réseau de GPU inutilisés en créant le réseau et le jeton RNDR basés sur Ethereum. Comme alternative aux fournisseurs de cloud coûteux, les clients envoient des tâches de rendu à un réseau d’ordinateurs, en payant leurs propriétaires à l’aide du jeton. L’ensemble des négociations et des contrats entre les parties est géré par le protocole en quelques secondes, sans qu’aucune des parties ne connaisse l’identité ou les spécificités de la tâche effectuée.

On se rend compte que la blockchain est en fait un mécanisme général permettant d'exécuter des programmes, de stocker des données et d'effectuer des transactions de manière vérifiable. C'est un sur-ensemble de tout ce qui existe en informatique. Nous finirons par la considérer comme un ordinateur distribué qui fonctionne un milliard de fois plus vite que l'ordinateur que nous avons sur nos bureaux, parce qu'elle est la combinaison des ordinateurs de tout le monde.

Tim Sweeney - Fondateur et PDG d'Epic Games (2017)

Une telle place de marché pourrait-elle fournir certaines des quantités massives de capacité de traitement qui seront requises par le Metaverse ? Imaginez que, lorsque vous naviguez dans des espaces immersifs, votre compte offre en permanence les tâches informatiques nécessaires aux appareils mobiles détenus mais inutilisés par des personnes proches de vous, peut-être des personnes marchant dans la rue à côté de vous, afin de rendre ou d’animer les expériences que vous rencontrez.

Bien sûr, plus tard, lorsque vous n’utiliserez pas vos propres appareils, vous gagnerez des jetons car ils vous rendront la pareille. Les partisans de ce concept de crypto-échange le considèrent comme une caractéristique inévitable de toutes les futures puces électroniques. Chaque ordinateur, aussi petit soit-il, serait conçu pour mettre aux enchères en permanence les cycles libres. Des milliards de processeurs disposés dynamiquement alimenteront les cycles de calcul profonds des plus grands clients industriels et fourniront le maillage informatique ultime et infini qui permettra le Metaverse.

"La Blockchain va être là pour longtemps et ce sera une nouvelle forme fondamentale d'informatique"

Jensen Huang - PDG de Nvidia (2018)