Qu’est-ce que le Metaverse ? Découvrez dans ce guide ultime, le rôle du matériel dans le Metaverse : grand public ou non.

Voici la deuxième partie de « Qu’est-ce que le Metaverse – le guide ultime pour tout comprendre », qui se concentre sur le rôle du matériel dans le Metaverse.

Le matériel est défini comme « la vente et le support des technologies physiques et des appareils utilisés pour accéder au Metaverse, interagir avec lui ou le développer. Cela inclut, sans s’y limiter, le matériel grand public (comme les casques VR, les téléphones mobiles et les gants haptiques) ainsi que le matériel d’entreprise (comme ceux utilisés pour exploiter ou créer des environnements virtuels ou AR, par exemple les caméras industrielles, les systèmes de projection et de suivi, et les capteurs de balayage). Cette catégorie ne comprend pas le matériel spécifique aux ordinateurs, comme les puces GPU et les serveurs, ni le matériel spécifique aux réseaux, comme le câblage en fibre optique ou les puces sans fil. »

Pas le temps de tout lire ? Clique pour aller directement à la partie qui t’intéresse le plus :

Matériel grand public

Chaque année, le matériel grand public bénéficie de capteurs plus performants, d’une plus grande autonomie, d’une haptique plus sophistiquée/diversifiée, d’écrans plus riches, de caméras plus nettes, etc. Nous voyons également un nombre toujours croissant d’appareils intelligents, tels que des montres, des casques VR (et bientôt des lunettes AR). Toutes ces avancées améliorent et étendent l’immersion de l’utilisateur, même si c’est le logiciel qui fournit l’expérience réelle ou la « magie ».

Considérons, à titre d’exemple limité, les applications d’avatars en direct telles que Bitmoji, Animoji et Snapchat AR. Ces applications dépendent de CPU/GPU assez performants, ainsi que de logiciels sophistiqués. Mais elles nécessitent également et sont enrichies par des caméras et des capteurs de suivi des visages puissants qui ne cessent de s’améliorer.

Les modèles d’iPhone les plus récents suivent désormais 30 000 points sur votre visage grâce à des capteurs infrarouges. Bien que ces capteurs soient le plus souvent utilisés pour Face ID, ils peuvent désormais être connectés à des applications telles que l’application Live Link Face d’Epic Games, permettant ainsi à tout consommateur de créer (et de diffuser) un avatar haute fidélité en temps réel, basé sur Unreal Engine. Il est clair que la prochaine étape pour Epic sera d’utiliser cette fonctionnalité pour faire correspondre en direct le visage d’un joueur de Fortnite à son personnage dans le jeu.

Utilisation de la caméra d’un iPhone pour animer un modèle 3D sur l’Unreal Engine

Quant à Object Capture d’Apple, il permet aux utilisateurs de créer en quelques minutes des objets virtuels haute fidélité à partir de photos prises sur leur iPhone standard. Ces objets peuvent ensuite être transplantés dans d’autres environnements virtuels, réduisant ainsi le coût et augmentant la fidélité des produits synthétiques, ou être superposés à des environnements réels à des fins d’art, de design et autres expériences de RA.

Object Capture permet de prendre une scène en photo et de la recréer avec des modèles 3D

De nombreux nouveaux smartphones, dont l’iPhone 11 et l’iPhone 12, sont équipés de nouvelles puces à bande ultra-large qui émettent 500 000 000 d’impulsions RADAR par seconde et de récepteurs qui traitent les informations en retour. Cela permet aux smartphones de créer des cartes RADAR étendues de tout, de votre maison à votre bureau, en passant par la rue dans laquelle vous marchez – et de vous placer dans ces cartes, par rapport aux autres appareils locaux, à quelques centimètres près. Cela signifie que la porte de votre maison peut se déverrouiller lorsque vous vous approchez de l’extérieur, mais rester fermée de l’intérieur. Et en utilisant une carte RADAR en direct, vous pourrez naviguer dans une grande partie de votre maison sans jamais avoir besoin de retirer votre casque VR.

Le fait que tout cela soit possible grâce à un matériel standard de qualité grand public est étonnant. Et le rôle croissant de cette fonctionnalité dans notre vie quotidienne explique pourquoi l’iPhone a pu augmenter son prix de vente moyen d’environ 450 dollars en 2007 à plus de 750 dollars en 2021, au lieu de se contenter d’offrir de plus grandes capacités au même prix.

Les casques XR sont un autre excellent exemple de progrès et de besoins exceptionnels en matière de matériel. Le premier Oculus grand public (2016) avait une résolution de 1080×1200 par œil, tandis que l’Oculus Quest 2, sorti quatre ans plus tard, avait 1832×1920 par œil (ce qui équivaut à peu près à la 4K). Palmer Luckey, l’un des fondateurs d’Oculus, estime que plus du double de cette résolution est nécessaire pour que la RV puisse surmonter la pixellisation et devenir un appareil grand public. L’Oculus Rift a également atteint un taux de rafraîchissement de 72hz, tandis que l’édition la plus récente atteint 90hz, et jusqu’à 120hz lorsqu’il est connecté à un PC de jeu via Oculus Link. Beaucoup pensent que 120hz est le seuil minimum pour éviter la désorientation et la nausée chez certains utilisateurs. Et l’idéal serait d’y parvenir sans avoir besoin d’un PC de jeu et d’un câble de connexion.

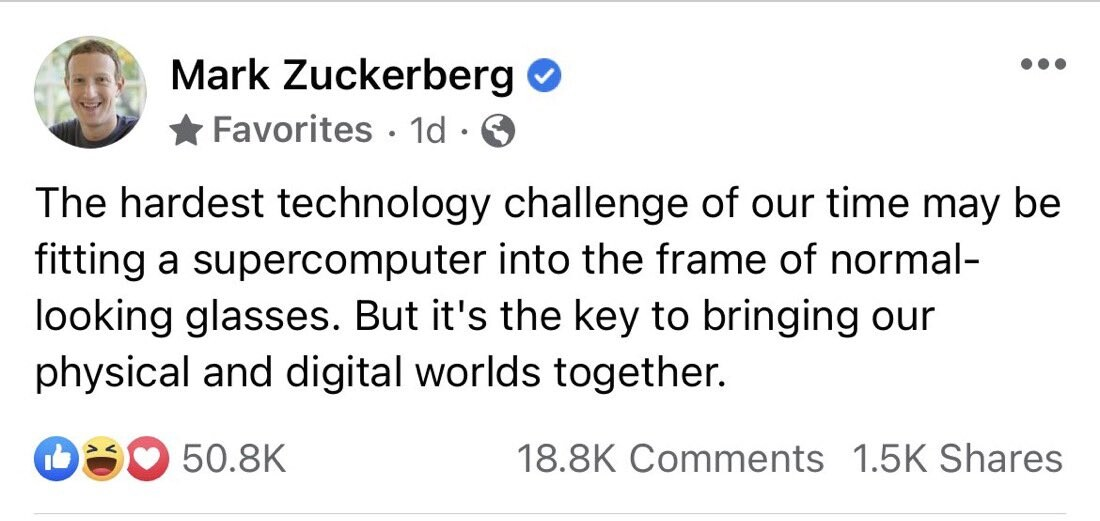

« Le challenge technologique le plus difficile de notre époque pourrait bien être de faire rentrer un super-ordinateur dans une simple paire de lunettes.

Mais il s’agit là de la clé pour réunir nos mondes réels et digitaux. »

Alors que les humains peuvent voir en moyenne à 210°, l’écran HoloLens 2 de Microsoft ne couvre que 52° (contre 34° auparavant). Les prochaines lunettes de Snap ne couvrent que 26,3°. Pour décoller, nous avons probablement besoin d’une couverture beaucoup plus large. Et il s’agit principalement de défis matériels, et non logiciels. Qui plus est, nous devons réaliser ces progrès tout en améliorant la qualité des autres éléments matériels contenus dans les lunettes (haut-parleurs, processeurs, batteries, etc.) et, idéalement, en les réduisant également.

Un autre exemple est le projet Starline de Google, une cabine matérielle conçue pour donner aux conversations vidéo l’impression d’être dans la même pièce que l’autre participant, alimentée par une douzaine de capteurs de profondeur et de caméras, ainsi que par un écran multidimensionnel en tissu et des haut-parleurs audio spatiaux. Tout cela est rendu vivant grâce au traitement et à la compression volumétriques des données, puis diffusé par webRTC, mais le matériel est essentiel pour capturer et présenter un niveau de détail qui « semble réel ».

Matériel non grand public

Compte tenu de ce qui est possible avec les appareils grand public, il n’est pas surprenant que le matériel industriel/de l’entreprise, dont le prix et la taille sont plusieurs fois supérieurs, étonne. Leica vend aujourd’hui des caméras photogrammétriques à 20 000 $ qui peuvent atteindre 360 000 « points de balayage laser par seconde » et qui sont conçues pour capturer des centres commerciaux, des bâtiments et des maisons entières avec une clarté et des détails supérieurs à ce que le commun des mortels pourrait voir en personne. Quant à Quixel d’Epic Games, il utilise des caméras exclusives pour générer des « MegaScans » environnementaux composés de dizaines de milliards de triangles précis au pixel près.

Ces dispositifs permettent aux entreprises de produire plus facilement et à moindre coût des « mondes miroirs » de haute qualité ou des « jumeaux numériques » d’espaces physiques, et d’utiliser des scans du monde réel pour produire des mondes imaginaires de meilleure qualité et moins coûteux. Il y a quinze ans, nous étions stupéfaits par la capacité de Google à capturer (et à financer) des images 2D à 360° de toutes les rues du monde. Aujourd’hui, des dizaines d’entreprises peuvent acheter des caméras LIDAR et des scanners pour construire des reproductions photogrammétriques 3D totalement immersives de tout ce qui existe sur terre.

Chinese gaming giant Tencent Games has applied its facial verification system to keep tabs on children and teenagers playing between 10 p.m. and 8 a.m.

— Sixth Tone (@SixthTone) July 6, 2021

“Anyone who refuses or fails the face verification will be treated as a minor … and kicked offline.”https://t.co/21qBmuFioR

Ces caméras deviennent particulièrement intéressantes lorsqu’elles vont au-delà de la capture d’images statiques et de la virtualisation, et qu’elles permettent le rendu et la mise à jour en temps réel du monde réel. Aujourd’hui, par exemple, les caméras d’un magasin Amazon Go permettent de suivre des dizaines de consommateurs en même temps via un code. À l’avenir, ce type de système de suivi sera utilisé pour reproduire ces utilisateurs, en temps réel, dans un monde miroir virtuel. Des technologies telles que Starline de Google permettront alors aux travailleurs à distance d’être « présents » dans le magasin (ou dans un musée, un DMV ou un casino) à partir d’une sorte de « centre d’appels Metaverse » délocalisé – ou peut-être chez eux, devant leur iPhone.

Lorsque vous allez à Disneyland, vous pourriez voir des représentations virtuelles (ou même robotiques) de vos amis à la maison et collaborer avec eux pour vaincre Ultron ou collecter les pierres d’infinité. Ces expériences nécessitent bien plus que du matériel, mais elles sont limitées, activées et réalisées grâce à lui.